长擎安全操作系统深度融合DeepSeek,共启国产AI新时代

近期,Deepseek-R1 大模型因其在强化学习后训练上的卓越表现,在数学、代码和自然语言推理等复杂任务上展现出强大实力,成为业内热议的焦点。与此同时,企业对数据安全、隐私保护以及本地化部署的需求日益迫切。如何在确保安全底座的前提下,利用前沿 AI 技术构建高效的智能知识库,正成为推动数字化转型的重要方向。

针对企业级场景,北京长擎软件有限公司研发的长擎安全操作系统24(CQOS24)提供了从内核到应用全方位的安全防护。该系统采用内核与应用一体化的安全机制及多策略动态安全框架,实现身份认证、细粒度访问控制、安全审计等关键安全功能,为企业数据的完整性、保密性和可用性提供了坚实保障。借助 CQOS24 的安全优势,企业可以在本地构建一个可信、独立的运行环境,防范网络攻击和数据泄露风险。

在企业信息化建设过程中,智能知识库能够有效整合海量数据,提升知识检索和决策支持能力。以Deepseek-R1为核心,通过其先进的推理能力,结合企业已有的数据资源,构建智能化知识管理平台具有显著优势。同时,借助开源工具Ollama和Dify,可以实现大模型的高效部署和私有化运行:

Ollama:作为基于 Go 语言开发的开源框架,简化了大语言模型(包括 Deepseek-R1)的安装、运行与管理,并提供与 OpenAI 兼容的 API 接口;

Dify:融合 Backend as Service 与 LLMOps 理念,为开发者和非技术人员提供直观、易用的生成式 AI 应用开发平台。

1、 基于CQOS24 的系统部署实践

在 CQOS24 环境下构建企业级智能知识库的实践步骤如下:

1.1部署Ollama 及 Deepseek-R1 模型

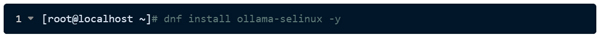

利用 CQOS24 提供的软件仓库,通过 YUM(或 DNF)命令安装 Ollama

下载Ollama的安全策略包(如果selinux未开启,不需要此步)

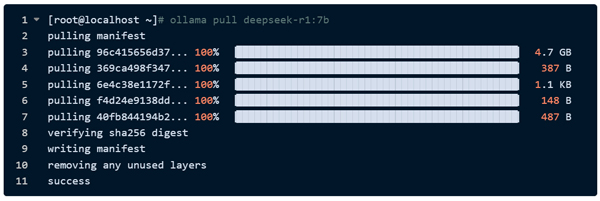

下载Deepseek-R1大模型

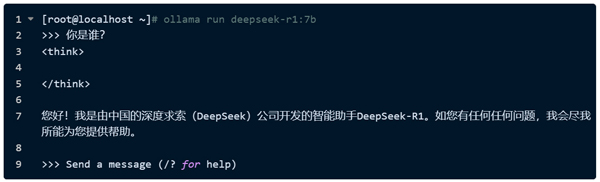

运行模型测试,验证效果

修改 Ollama 服务配置,设置监听地址(Environment="OLLAMA_HOST=0.0.0.0"),确保模型接口可供外部访问

重启ollama服务

配置防火墙策略,开放对应端口(如 11434/tcp),为后续 Dify 平台调用提供网络支持

1.2部署Dify平台构建智能应用

在 CQOS24 上安装 Docker 环境,确保容器化部署环境就绪

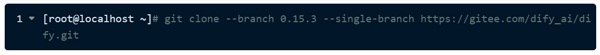

克隆Dify源码

下载docker-compose工具

注: dify的docker部署方式要求docker-compose 的版本≥1.28

制作docker-compose策略包(如果selinux未开启,不需要此步)

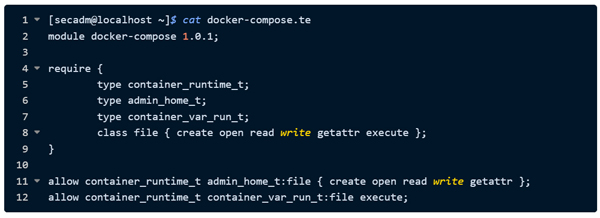

使用安全管理员secadm登录,创建docker-compose.te文件并填写策略内容

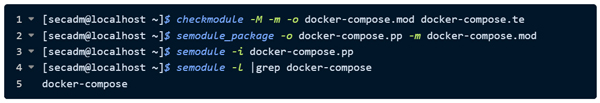

编译并加载docker-compose.pp文件

进入 Dify 部署目录,复制环境配置文件后启动容器

通过浏览器访问服务器 IP 下的 /install 页面,完成 Dify 的初始化配置

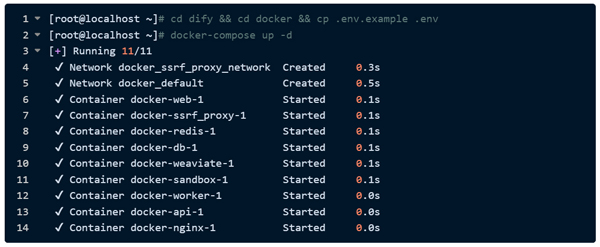

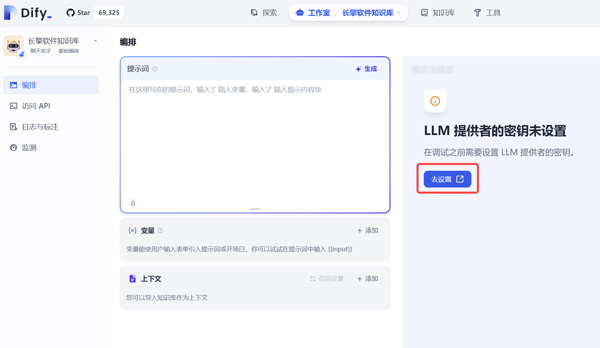

在Dify中创建聊天助手

在创建的聊天助手中添加ollama模型

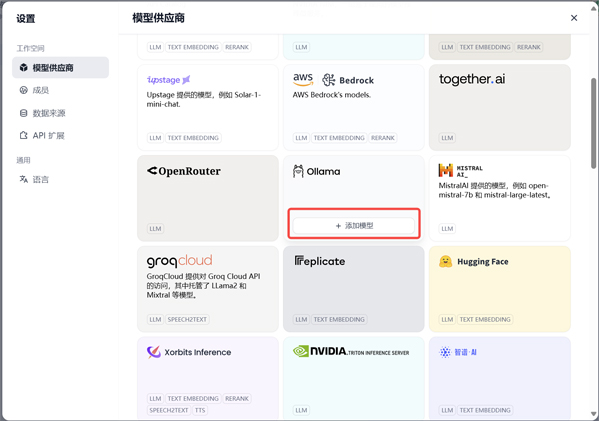

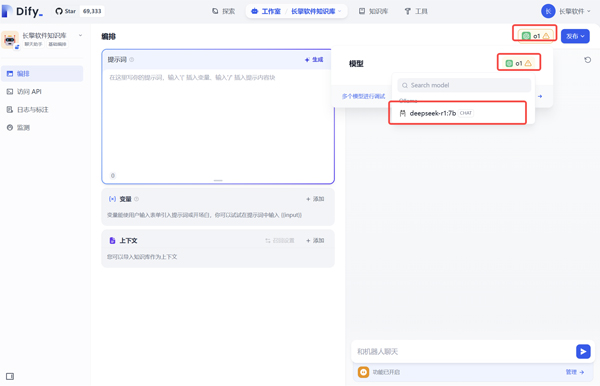

启用ollama模型

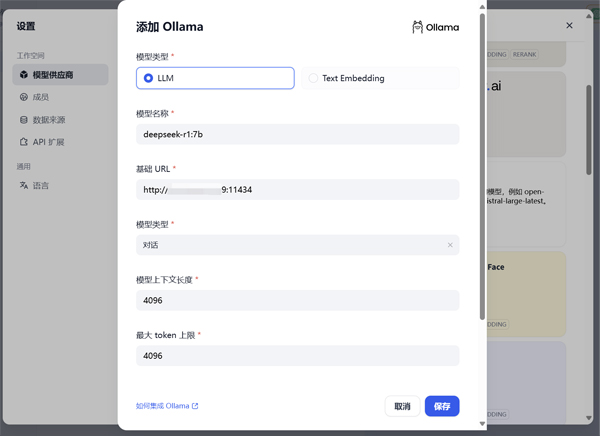

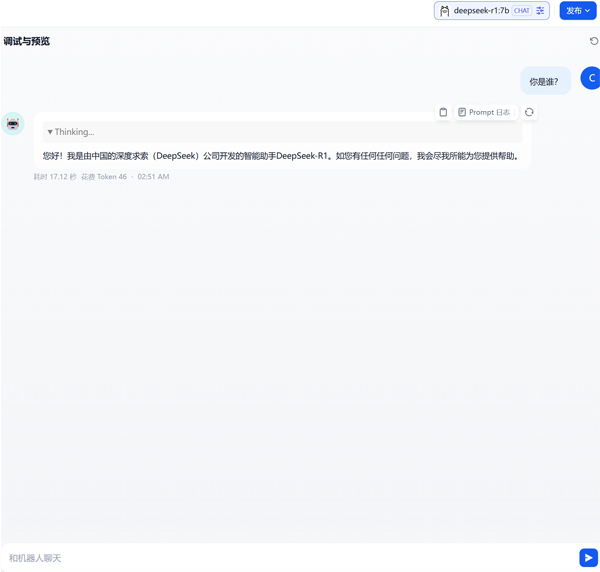

打开设置,添加ollama 模型列表,Deepseek 模型进行对话测试

1.3. 知识库搭建与测试

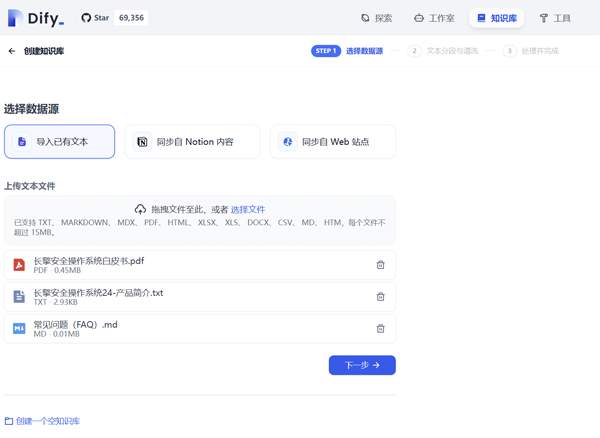

在 Dify 平台中创建知识库

导入知识库文件

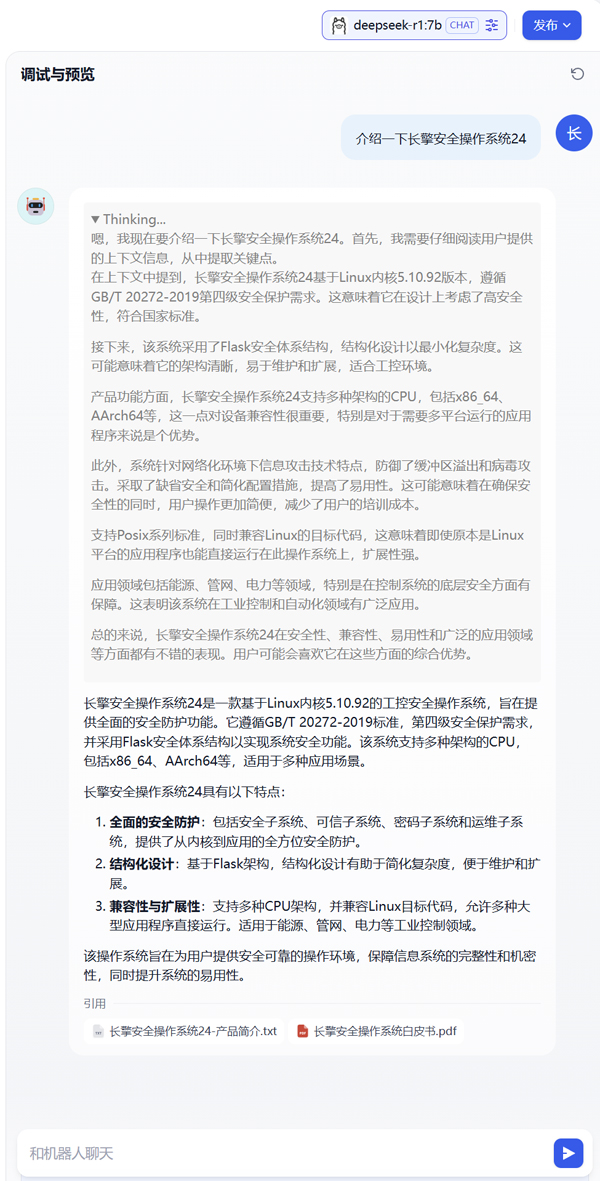

配置聊天助手引入上下文,实现基于知识库的智能问答和数据检索功能

2、 测试

基于长擎安全操作系统24构筑的自主可控技术底座,深度融合Deepseek-R1大模型的智能推理能力,依托Ollama与Dify平台的高效协同架构,企业可打造符合等保要求、支持智能决策的本地化知识中枢。随着AI技术向纵深发展,这种安全可靠的智能化解决方案将持续拓展企业创新边界,为产业升级注入全新生机。长擎安全操作系统24始终聚焦数字基建核心需求,通过构建内生安全防护体系与高性能运行环境,为AI技术的产业化落地提供可信赖的基础支撑,助力企业把握数字化转型战略机遇。